近些年计算力需求的增长直接推动了社会的进步。随着新基建时代的到来,5G网络,人工智能以及工业互联网将会获得飞速发展。举例来说,2016年,全球最大的数据中心大约是58万平方米,但是到了2019年,已经达到了99万平方米,相当于140个足球场。在三年的时间里,最大规模数据中心的面积增长了75%。这就充分说明社会经济进步对于计算力的巨大需求。在这样的背景下,提供超强算力的大型数据中心,以及服务近场数据处理的边缘数据中心势必会加快建造和部署。

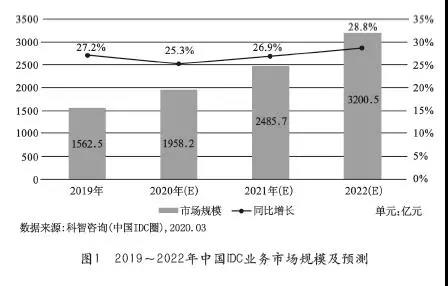

据科智咨询(中国IDC圈)最新发布的《2019-2020中国IDC产业发展研究报告》预计,2019~2022年中国IDC业务市场规模复合增长率为26.9%。图1为2019~2022年中国IDC业务市场规模及预测。

一、传统制冷方式总结

(1)紧耦合或热源冷却

紧耦合冷却方式通过贴近热源来实现更有效的运作。这不算什么新东西——问问老的大型机操作员或任何笔记本电脑设计人员就知道了。虽然紧耦合冷却在数据中心里面还是“主流”,但是更新的方法在满足能源效率的需求方面往往做得更好,并获取更多关注。它的工作方式很简单:消耗能源来将大量的空气吹入地板下的空间或者导风管,然后又将这些空气拉回至空调。

更有前途的技术包括浸入式冷却:将服务器整个浸泡在矿物油里,以便使用最少的能耗获得极高的冷却效率。但是技术人员需要对内外布满了石油的服务器进行处理时,心里会怎么想?显然这种冷却方式并不是适合所有场景。部分也是因为水冷方式重新受到关注。如果将巨大的机房空调系统取消,改用贴近设备的新型冷却方式的话,相信数据中心行业会运行得比现在更好。教育背景和希望与众不同的个人意愿或许会促生新案例,但成本和电源可用性的矛盾将决定最终结果。

(2)更高的运行温度

美国供暖、制冷和空调工程师协会(ASHRAE)在2008年就第一次发表了关于较高温度数据中心的建议,但并未引起注意。服务器不需要冷藏。即使入口空气温度达到华氏75到80°F(摄氏25至27°C),这些设备仍然能维持良好运作。服务器制造商实际上已经扩展了产品的运行温度范围,而且旧设备其实也和新设备一样能够在扩展的温度区间内运行。提高运行温度可以大幅度节省能源消耗,但人们首先需要认可这种处理方式,然后同意让热通道变得更热——想像一下100°F (38°C)的温度怎样?这会刺激后门冷却器的应用和普及。

(3)免费冷却

更高的运行温度通常也会让免费冷却系统一起受益。在ASHRAE 90.1-2010指导文件中,免费冷却几乎是一项节约能源的强制要求,必将被普遍运用。节能改造的资本投入会部分地抵消运营成本节约的好处。但在改造或升级的同时实现免费冷却也是技术和投资上的挑战。预计未来两年内将出现新的标准,使免费冷却更具可行性。靠近水源的免费冷却将可能会更具优势,但我们将会看到更多类似日本Kyoto Wheel的空气冷却案例。最终,数据中心运营商将能够在超出以前预计的更多气候条件下采用免费冷却措施,这部分是因为更高运行温度的贡献。

(4)蒸发或绝热冷却

虽然使用蒸发方式制冷的科学原理简单,并正在逐渐流行,但它对于大多数数据中心操作人员而言仍然显得新奇。绝热冷却通过降低封闭环境中的某种物质运行的压力来实现冷却,让这些物质沸腾如同岩浆涌上火山表面,同时用风带走山峰上的高温。绝热冷却在温暖、干燥的气候中仍然有效,这大大拓宽了一年中能够“免费冷却”的有效期。其主要的缺点是用水量有些多,但在同等冷却量的情况下,它所需的冷却水仍然比标准冷却塔要少很多。

(5)密封冷却

密封措施也无法解决由于错误的冷却规划、空气流动不充分或冷却能力引起的过热问题。最新的国家防火协会商业标准(NFPA-75)可能会使密封冷却的方案更难实现。对喷淋和(或)气体灭火系统的改造将大大增加成本。除了要尽力避免错误的实施外,日常优化也很重要:在未使用的机架空间一定要安装盲板,架空地板上的孔洞要及时封堵,地板下面影响通风的线缆也要做好清理。

(6)烟囱式机柜和天花板风道

使用天花板上方的空间形成的风道将空气传输给机房空调系统,确保回风以最高的温度返回空调冷却盘管,可以显著增加精密空调系统的冷却能力。结合了吊顶风道和热通道措施的最终设备形式就是烟囱式机柜,可以获得最大的冷却效率。来自服务器群的高温废气从机柜后部的烟囱排出,然后直接通过吊顶天花板上方的风道回到空调设备中。整个过程中热空气和冷空气保持分离,所以可以保持很高的能效比。

虽然效果明显,但是烟囱式机柜并没有获得大力推广或被广泛接受。这可能是因为全密封式的设计灵活性更好,可以使用更多的机柜实现相同的效果。然而,烟囱式机柜可以让整个房间维持冷通道温度,让工作环境变得更加舒适。

首先,和传统的风冷技术相比,液体导热能力是空气的25倍,同体积液体带走热量是同体积空气的近3000倍;其次,同等散热水平时,液冷噪音水平比风冷噪音降低20~35分贝;另外,在耗电量方面,液冷系统约比风冷系统节省电量30%~50%;最后,液冷还可以降低数据中心的故障率。传统的风冷系统会带来空气的流动而产生振动,振动会直接影响IT系统的稳定性和寿命。但液冷则完全不必担心这个问题。由此不难发现,液冷在未来取代风冷和水冷空调在技术上完全没有障碍。一旦数据中心的制冷方式从风冷转为液冷,那么随之发生改变的还有服务器的设计,以及整个数据中心的设计。如果液冷技术进一步完善,生态系统进一步成熟,那么将引发一连串的“革命”。

二、新基建时代浸没式液冷将成主流

事实上,出于多种因素的考虑,在数据中心液冷领域也演化出了诸多“门派”。其中最典型的分别是浸没式、冷板式以及喷淋式。不过无论是从当前需求还是从未来数据中心的技术演进来看,浸没式液冷相比于其他两种方式更被行业看好。

浸没式液冷是数据中心的跃迁式技术创新,具有高能效、高密度、高可用和高可靠等特性。浸没式液冷突破技术瓶颈,可以使单机柜功率密度提升3倍以上;同时,IT部件故障率大幅降低,有效提升云服务品牌。浸没式液冷可以为社会节省大量能源,预计2030年浸没式液冷可节约用电1637.77亿千瓦时,将数据中心的总用电量降低至2477.23亿千瓦时。事实上,除了行业专家和企业用户的高度关注以外,近两年来,很多设备厂商也加大了针对数据中心液冷市场的产品开发力度。

可以说,在未来新基建时代,大型数据中心将有望成为浸没式液冷技术的天下。不过需要说明的是,由于需要对建筑结构进行“伤筋动骨”的改造,所以浸没式液冷并不适用于对已建成数据中心的系统升级。另外,目前风冷还能够满足市面上热负荷较低的EDC或者小型数据中心,完全没有必要更换价格昂贵的液冷系统。

浸没式液冷案例

11月3日,在阿里巴巴双11技术沟通会上,阿里巴巴副总裁、阿里云基础设施负责人周明表示,为支撑屡创纪录的交易峰值,2020年双11将有包括张北、乌兰察布、河源、南通、杭州在内的五大超级数据中心合力支撑,让消费者们享受丝般顺滑的”剁手”体验。其中在杭州数据中心内,全球规模最大的液冷服务集群将有上万台液冷服务器投入生产处理双11的海量计算工作,这些服务器的网线连起来,可以绕地球一周。

将建立10座绿色超级数据中心

据悉,阿里巴巴重构了业内罕见的”给服务器泡澡”冷却技术——工程师将服务器浸泡在特殊的绝缘冷却液中,散热全程无需风扇、空调等制冷设备,大大降低了数据中心的能耗,整体节能超70%,年均PUE可达1.09,全球最低。除了硬件外,阿里工程师还设计了一套适合浸没液冷的监控管理系统,故障率降低了50%。

这也是全球唯一投入大规模部署的液冷集群,近十亿剁手党们在消费的同时还将创造史上最绿色环保的双11。初步估算,相比传统数据中心,阿里云杭州数据中心可每年省电7000万度,相当于西湖周边所有路灯连续点亮8年的耗电量。假如全中国所有的服务器都采用液冷技术,每年将节省超过800亿度电,接近三峡大坝一年的发电量。未来阿里云还将在全国建立10座以上的绿色超级数据中心,支持数字新基建发展。

结语

综上所述,从长远角度而言,社会对于计算力的需求永无止境,而机房的冷却技术发展将在很大程度上决定数据中心计算力提升的瓶颈高低。浸没液冷技术作为一种高效,节能,安全的冷却技术,在新基建时代,将成为大型和超大型数据中心的最佳选择。